Una nuova tecnologia su cui sta lavorando EA potrebbe rivoluzionare il modo in cui i videogiochi partendo dalla gestione delle animazioni, racconta il ricercatore della compagnia Sebastian Starke in un’intervista rilasciata a Inverse.

L’innovazione risiederebbe nell’utilizzo del machine learning per sostituire e migliorare, se non in tutto almeno in parte, il motion capture, l’attuale sistema di cattura dei movimenti dei personaggi. Ma vediamolo più nel dettaglio.

Il problema delle animazioni al giorno d’oggi secondo EA

Il sistema più credibile per la creazione delle animazioni di cui l’industria videoludica dispone oggi è il motion capture, .che in breve consiste in attori, stunt men e comparse che si muovono indossando tutine attillate e ricolme di sensori che mappano i movimenti del corpo e del viso. Questo metodo viene impiegato sia per le cinematiche che le sequenze di gioco.

Il processo di creazione di movimenti complessi è un lavoro tedioso, complicato e costoso, che parte da ben prima del momento in cui si utilizzano le tute. Questo racconta Starke, esperto di I.A presso Electronic Arts (EA) e ricercatore dell’Università di Edimburgo che sta da tempo lavorando a una soluzione alternativa.

Con il miglioramento della tecnologia di motion capture e l’aumento della precisione nella registrazione di ogni movimento, spiega, gli sviluppatori riescono a ottenere animazioni sempre più accurate e precise, ma purtroppo non si è ancora riusciti a utilizzare i dati che si acquisiscono in maniera tale da poterli armonizzare tra loro.

Per esempio, se si è pensato un set di mosse in combinazione per un personaggio e si vuole ottenere un’animazione fluida, magari una serie di calci, in motion capture l’attore di riferimento dovrà compiere la sequenza tutta di seguito, perchè il sistema di gioco non è in grado di computare le transizioni in autonomia o compiere aggiustamenti creativi che seguano i comandi del giocatore.

Perciò, il risultato sono spesso animazioni grattuggiate che alternano movimenti netti ad altri claudicanti, specialmente nel momento in cui si mandano molteplici comandi di movimento contemporaneamente.

Inoltre non c’è modo di aggiungere dettagli in post-produzione senza che si creino bug: tentare ne può creare anche di considerevoli come mani, braccia o gambe che si piegano innaturalmente, occhi impazziti e addiittura personaggi che si accartocciano, come capitato nel terribile caso del lancio di Mass Effect: Andromeda.

Nel migliore dei casi il risultato è un grande dispendio di tempo, soldi ed energie che spesso i publisher non sono disposti a permettere, penalizzando l’immersione dei giocatori.

Sebastian Starke e il machine learning: animazioni più complesse e videogiochi meno pesanti

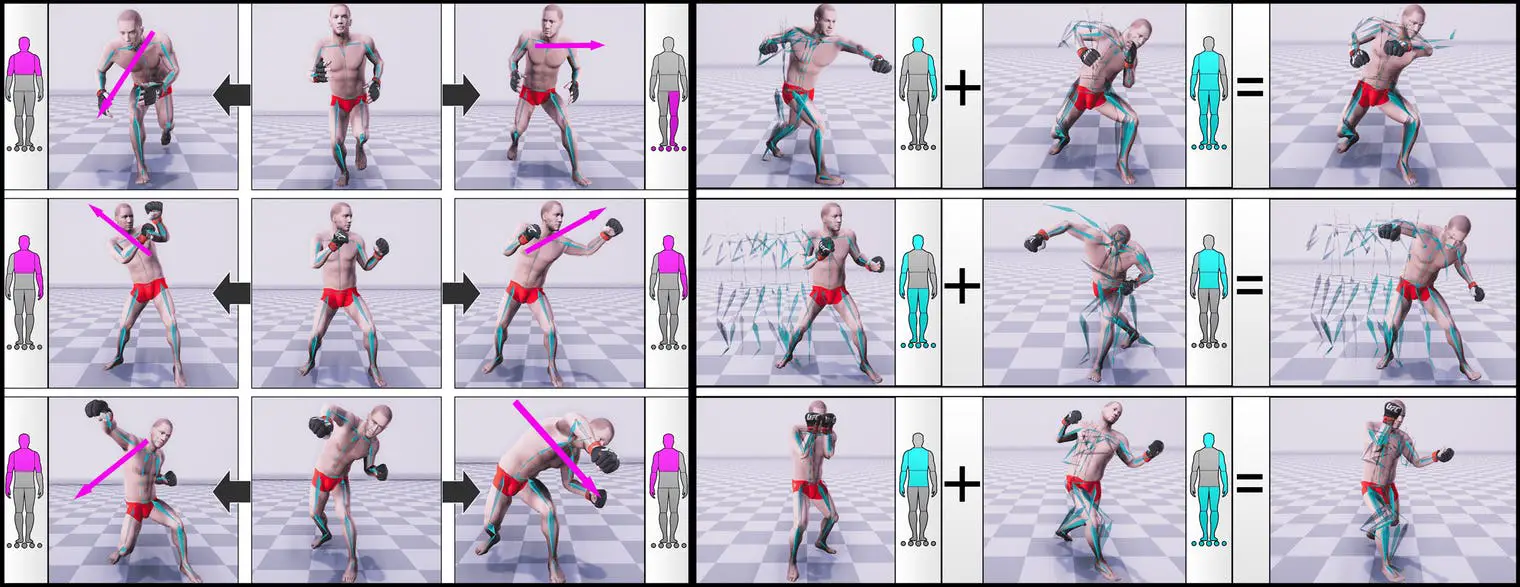

La soluzione a cui sta lavorando Sebastian Starke (al momento ancora in fase di sperimentazione) punterebbe a colpire il problema alla radice, riducendo l’utilizzo del motion capture. L’obiettivo sarebbe “insegnare” al motore di un gioco a creare le necessarie transizioni partendo da una base di movimenti raccolti con attori veri.

Per riuscire in questa impresa sarebbe sufficiente registrare un numero abbastanza ampio di mosse in motion capture e poi il sistema si preoccuperebbe di ricostruire i movimenti in sequenze fluide, realistiche e più adatte alla situazione. Nella presentazione di seguito si possono già osservare i primi promettenti risultati.

Il progetto permetterebbe quindi non soltanto di ottenere più animazioni a prezzi più bassi, e non soltanto di ridurre i glitch, ma anche di diminuire lo spazio che i giochi occupano in memoria, visto che si eliminerebbero svariate decine di gigabyte di mosse avanzate che prima si dovevano tediosamente accumulare dal vivo.

Ad oggi non ci sono ancora applicazioni pratiche per questo progetto, ma possiamo ben sperare per il futuro. Per saperne di più, ecco di seguito la presentazione del lavoro di Starke, introdotto a SIGGRAPH 2021.